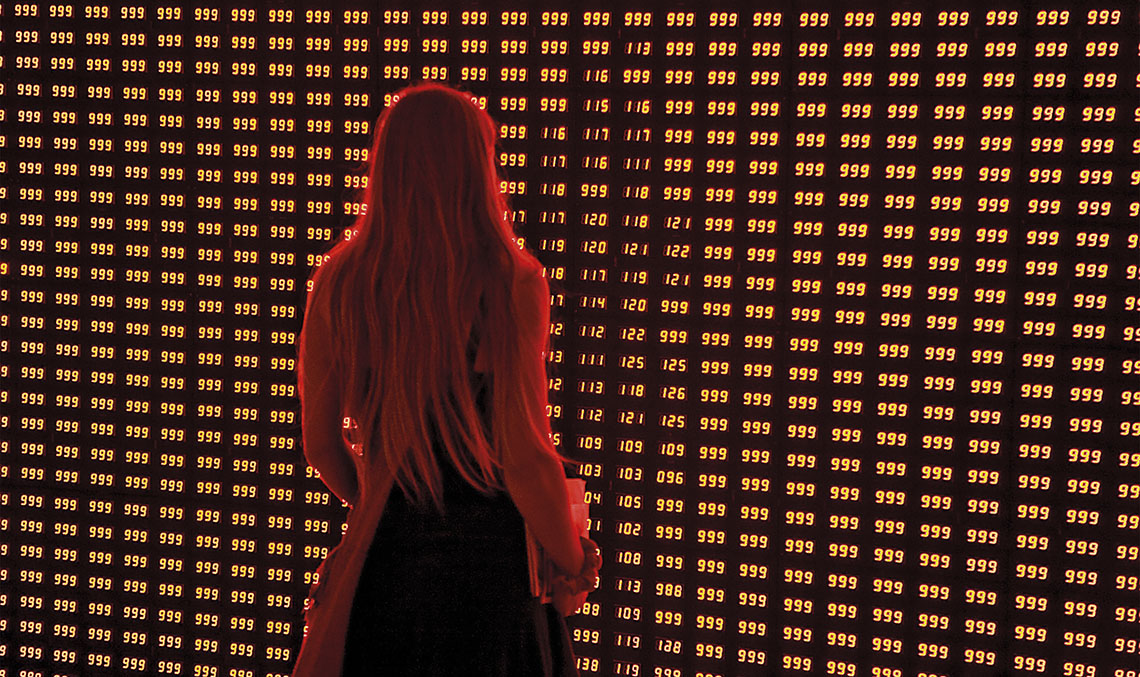

La previsión de crecimiento hasta el 2020 es de casi 40ZB (zettabyte, 1021 bytes), la mayor parte generada por seres humanos, seguido por dispositivos físicos conectados a Internet. Otro indicador que nos permite constatar esta tendencia es que el mercado de la tecnología y analítica Big Data crece a razón del 20-30% anualmente, con un mercado mundial estimado en 50.000 millones de euros hasta 2018.

Pero no es solo el volumen de datos lo que hace característico al concepto Big Data. Tendemos a hacer la traducción y asociarlo al concepto de gran cantidad de información, pero como veremos más adelante, se deben dar más características para considerar un conjunto de datos como Big Data.

Definición de Big Data y problemática asociada

Podemos hablar de Big Data cuando se generan grandes cantidades de información (Volumen), de manera muy rápida (Velocidad), con tipos de datos heterogéneos (Variedad). A las clásicas tres características (las tres Vs), recientemente la industria ha empezado a añadir una cuarta, Veracidad. Dado que gran parte de la información se genera directamente por personas, es necesario dotar al origen de datos de la característica de veracidad. De nada nos sirve tener una fuente completa de datos que no es fiable.

En gran medida, el auge de las tecnologías Big Data ha venido de la mano de las redes sociales, en cuanto al volumen y variedad de datos, y del sector del marketing en cuanto a las posibilidades de poner en valor toda la información que se está generando. La banca es otro de los sectores clásicos de generación y explotación de Big Data. El estudio de la información de usos y costumbres que se pueden obtener de la información bancaria permite desde diseñar productos adaptados al cliente, a predecir comportamientos, como impagos, en base a la correlación de la información disponible. También las ingenierías empiezan a identificar casos de uso donde la capacidad de análisis de Big Data supone una ventaja competitiva.

Por último, cabe destacar el ámbito de IoT (Internet of Things) y las Smart Cities. El concepto Smart City implica un uso intensivo de las tecnologías de la información para recoger y procesar la información que genera la ciudad basada en los sensores desplegados u otros orígenes de datos como pueden ser cámaras de tráfico o cualquier otra fuente de información no estructurada.

Las cuatro características que debe cumplir la información para que se identifique con el concepto Big Data son: volumen, velocidad, variedad y veracidad

La orientación de la industria

Los proyectos Big Data no pueden ser abordados de forma eficiente con las tecnologías tradicionales. Las necesidades de almacenamiento y explotación de tal cantidad de datos, con sus características de velocidad y heterogeneidad, ha obligado a la industria a diseñar nuevas tecnologías que permitan trabajar con información en tiempo real, y con las características de volumen y variedad de datos anteriormente mencionados.

Entre los diferentes paradigmas que presenta la industria para acometer proyectos Big Data podemos destacar las tecnologías In-Memory (IMDB) y los Sistemas Distribuidos. La tecnología In-Memory permite cargar toda la información con la que se necesita trabajar en memoria, donde el procesamiento es mucho más rápido. Por otro lado, las soluciones basadas en sistemas distribuidos se orientan al procesamiento paralelo, permitiendo descomponer y resolver un problema complejo usando diferentes máquinas que se encargan de resolver cada parte del problema original. Esta descomposición permite utilizar ordenadores económicos, pero que en conjunto componen una gran plataforma de procesamiento. A esta tendencia ha ayudado la aparición de soluciones Open Source como Hadoop o Storm.

Por otro lado, existe una tendencia de implementar las plataformas Big Data usando servicios en la nube (cloud). El problema que se plantea en los proyectos Big Data es el dimensionamiento y la escalabilidad (capacidad de crecimiento) de la infraestructura. Por este motivo, este tipo de proyectos necesitan disponer de una infraestructura que sea elástica, y que permita ampliar o disminuir los recursos disponibles basándose en los requerimientos que dispongamos en cada momento.

Las soluciones basadas en servicios en la nube se van a imponer a la contratación de la infraestructura privada (on premise), ya que permite a las empresas liberarse de las tareas de instalación y mantenimiento de la infraestructura, para centrarse en tareas que aporten valor al proyecto. Ya no hablamos de adquirir máquinas (virtuales o físicas) donde hemos instalado y configurado nuestra propia solución, sino de utilizar los servicios que necesitemos en cada momento, pagando solo por el tiempo de procesamiento y por el almacenamiento. Por ejemplo, si necesitamos un servicio de aprendizaje automático, donde poder definir un algoritmo de predicción que trabaje con nuestra propia información, basta con contratar el servicio en la nube y pagar solo por el tiempo de uso.

Lo que esconde el Big Data

Una vez que tenemos esta ingente cantidad de datos, ¿cómo generamos valor a partir de nuestra información? Existe el error de pensar que los proyectos Big Data consisten en almacenar la información existente y aplicar tecnología más o menos compleja para analizar qué es lo que podemos obtener. Un proyecto Big Data debe comenzar antes de empezar a recopilar la información. Es necesario tener claro los objetivos que motivan el proyecto, qué tipo de información necesitamos y plantear todos los condicionantes implicados en la recolección y procesamiento de la misma.

A diferencia de la tecnología Big Data, los sistemas clásicos de inteligencia de negocio (Business Intelligence) se basan en la consolidación de la información que nos permita realizar operaciones con esos datos precalculados. El nuevo paradigma de Big Data nos obliga, por un lado, a tener la capacidad de analizar el flujo de información en tiempo real, y por otro, almacenar la información en bruto. Por ejemplo, en el caso de sensores de temperatura, necesitamos registrar todas las medidas que ha generado el sensor. No es suficiente con manejar la temperatura media por día, ya que al disponer de la información agregada no nos permite analizar el detalle para poder llegar a predecir el comportamiento de los parámetros o identificar patrones de comportamiento. Es decir, necesitamos poder almacenar y analizar la información en el estado original, o con nivel de granularidad mucho menor que en los sistemas analíticos tradicionales.

Big Data en la ingeniería

Los campos de aplicación son muy amplios, desde las soluciones para Smart Cities hasta las técnicas de aprendizaje automático para actividades de mantenimiento predictivo. En Ineco somos conscientes de la importancia y posibilidades que tienen las tecnologías de Big Data en el campo de la ingeniería. Por ese motivo, la subdirección de Tecnologías de la Información estudia y explota las características de Big Data en diferentes ámbitos. En el caso de las Smart Cities trabajamos en diferentes campos, donde podemos destacar la plataforma Smart CityNECO, para la integración de la información de los diferentes servicios de la ciudad (movilidad, medio ambiente, etc.) permitiendo la correcta gestión basada en los cuadros de mando de los diferentes servicios que proporciona la ciudad. Por otro lado, también dentro de ámbito de las Smart Cities, pero más concretamente en el vertical de movilidad (Smart Mobility), Ineco trabaja en el estudio y optimización de la movilidad en las ciudades, creando entornos de simulación y predicción en tiempo real que permitan determinar los parámetros óptimos de regulación de la movilidad en las diferentes áreas de la ciudad. Esta solución se basa en la integración de los modelos de simulación, así como en técnicas de aprendizaje automático, trabajando con la información en tiempo real del estado de la movilidad en la ciudad.

Un proyecto Big Data debe tener claro los objetivos, qué tipo de información necesitamos y plantear los condicionantes implicados en la recolección y procesamiento de la misma

Dentro del ámbito de mantenimiento de infraestructuras, el mantenimiento predictivo se basa en prever el problema antes de que este se produzca o de que se pierdan las condiciones óptimas en su estado. De esta forma, alargamos los tiempos entre actuaciones de mantenimiento, mejorando la disponibilidad a la vez que se ahorra en costes. En este campo, desarrollamos técnicas predictivas a partir de mediciones de diferentes parámetros gracias al establecimiento de sensores, que permitan establecer una relación con su ciclo de vida. La diferencia con las técnicas tradicionales radica en combinar toda la información del estado, sus características, la explotación, así como condiciones medioambientales de una forma automática.

Dentro de la actividad de aforos y encuestas de movilidad, Ineco trabaja en una plataforma de encuestas con dispositivos móviles, que permite la recopilación de toda la información relevante para este tipo de estudios, entre las que se encuentran las respuestas que proporciona el usuario, la información de ubicación proporcionada por el GPS, etc. Además, sobre las contestaciones que se realizan en lenguaje natural, podemos realizar lo que se denomina ‘Análisis de Sentimiento’ (minería de opinión) lo cual nos permite identificar la actitud del interlocutor con respecto a un tema.

Por otro lado, no podemos olvidar que Big Data no solo contempla información alfanumérica. Por ese motivo, otro de los campos de investigación se centra en el tratamiento de imágenes. El objetivo es la localización de defectos u objetos de una forma automatizada.

En conclusión, estamos sufriendo una transformación digital, que unida a las capacidades de interconexión, está aumentando exponencialmente la cantidad de información generada. Nos encontramos en la ‘Era del Dato’ y las capacidades de análisis de esa información va a marcar la diferencia en todos los ámbitos empresariales.